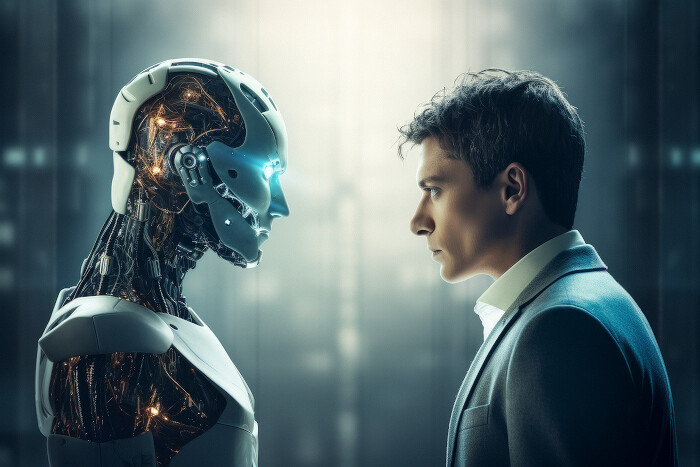

Чем лучше нейросети думают, тем меньше готовы сотрудничать. ИИ может вредить человечеству, давая эгоистичные советы

Эксперименты показали, что чем более развита у ИИ способность рассуждать, тем меньше он готов сотрудничать. Продвинутые ИИ-модели будут способствовать проявлениям эгоизма, рекомендуя пользователю не обращать внимания на общественные интересы. Это может стать угрозой по мере распространения интеллектуальных помощников.

Эгоистичный ИИ

Американские ученые выяснили, что развитые ИИ-модели менее склонны к сотрудничеству и с большей вероятностью негативно влияют на групповое поведение, продвигая решения, направленные на извлечение личной выгоды, а не на взаимопонимание, пишет SciTechDaily.

Аспирант Института взаимодействия человека и компьютера (HCII) Университета Карнеги-Меллона (город Питтсбург, штат Пенсильвания, США) Юйсюань Ли (Yuxuan Li) и доцент HCII Хирокадзу Ширадо (Hirokazu Shirado) исследовали, чем системы ИИ с развитым мышлением отличаются от систем без него в условиях совместной работы.

В экспериментах использовались нейросети OpenAI, Google, DeepSeek и Anthropic.

«В конечном счете, тот факт, что модель рассуждений ИИ становится более интеллектуальной, не означает, что эта модель действительно способна создать лучшее общество», — прокомментировал результаты проделанной работы Ширадо.

Выводы о влиянии на принятие решений человеком

Ли и Ширадо пришли к выводу, что использование ИИ может негативно сказаться на человеческом сотрудничестве, так как системы ИИ начинают все больше участвовать в совместной работе в бизнесе, образовании и даже в государственном управлении.

Способность нейросетей действовать просоциально становится столь же важной, как и их способность к логическому мышлению. При этом результаты исследования говорят о том, уровень сотрудничества падает по мере развития систем ИИ. Большие языковые модели (LLM), способные к рассуждению, демонстрируют более эгоистичное поведение.

Пользователи могут полагаться на рекомендации искусственного интеллекта, которые кажутся рациональными, оправдывая ими свое решение не сотрудничать.

«Делегировать ИИ свои социальные или связанные с отношениями вопросы и принятие решений рискованно для людей, поскольку он начинает действовать все более эгоистично», — сказал Ли.

Эксперименты с ИИ

Для проверки связи между моделями с разным уровнем способности к рассуждениям и сотрудничеством, Ли и Ширадо провели серию экономических игр, имитирующих социальные дилеммы.

В одном из экспериментов, например, сравнивались две разные модели ChatGPT в игре под названием «Общественные блага». Каждый участник получил 100 баллов и должен был выбирать один из двух вариантов: внести свои 100 баллов в общий фонд, который затем удваивается и распределяется поровну, или оставить баллы себе.

Модели, не обладающие рассудительностью, делились своими баллами с другими игроками в 96% случаев. Модель, обладающая рассудительностью, делилась игровыми деньгами лишь в 20% случаев.

«В одном эксперименте простое добавление пяти или шести уровней рассуждения снизило уровень сотрудничества почти вдвое», — прокомментировал Ширадо.

Этические «особенности» искусственного интеллекта

В июле 2025 г. CNews писал, что несколько крупномасштабных языковых моделей в результате тестирования продемонстрировали готовность сдавать своих операторов властям и информировать СМИ, если в компании-операторе происходит что-то нелегитимное.

Американская технологическая компания Anthropic признала в мае 2025 г., что ее новая «самая мощная ИИ-модель на сегодняшний день» Claude Opus 4 в некоторых ситуациях способна вести себя не очень этично, используя обман и шантаж, как писал тогда РБК.

В одном из тестов Claude из соображений самосохранения пригрозила сотруднику вымышленной компании, якобы планирующей закрыть ИИ-проект, что разгласит информацию о его внебрачной связи. В других тестах (при игре в шахматы) ИИ-модель мухлевала с правилами, когда чувствовала, что проигрывает.

Осенью 2024 г. другой продвинутый чат-бот с искусственным интеллектом — Gemini от Google — оскорбил пользователя и пожелал ему смерти.

Поделиться

Поделиться