Selectel разработал Inference-платформу для сокращения сроков запуска ML-моделей

Selectel, провайдер сервисов ИT-инфраструктуры, объявляет о старте бета-тестирования собственной Inference-платформы, предназначенной для упрощения запуска ML-моделей в промышленную эксплуатацию и ускорения их работы. Новый сервис позволит за несколько минут развернуть готовую ML-модель на вычислительных мощностях провайдера без привлечения разработчиков. Об этом CNews сообщили представители Selectel.

Решение актуально для компаний, в бизнес-процессах, продуктах или сервисах которых часть задач решается ML-моделями: голосовые роботы для автоматизации работы колл-центра, чат-боты для консультаций сотрудников и клиентов, сервисы распознавания изображений и другие задачи. С помощью Inference-платформы можно загружать желаемые ML-модели в объектное хранилище Selectel, а в результате получать готовые API-интерфейсы без разработки. Также решение дает возможность регулярно обновлять версии ML-моделей без прекращения обработки поступающих пользовательских запросов, что позволяет избежать простоев и обеспечить необходимую крупным компаниям эффективность и стабильность сервисов.

Использование Inference-платформы дает возможность в несколько раз сократить время вывода ИИ-проектов на рынок, причем с учетом конкретных профилей нагрузок и требований к производительности. Такая кастомизация достигается за счет привлечения специалистов ML-команды Selectel к подбору конфигураций и донастройке инфраструктуры.

«Selectel помог множеству компаний построить инфраструктуру для решения самых разных ИИ- и ML-задач. Накопленная за последние годы экспертиза помогает развивать существующие продукты, а также запускать новые. В прошлом году линейка наших продуктов пополнилась кастомизируемой ML-платформой для обучения моделей, клиентский опыт использования которой помог лучше понять актуальные ожидания от платформенных ML-продуктов, — отметил Антон Чунаев, менеджер ML-продуктов Selectel. — Зрелость российского рынка ИИ увеличивается, появляется большое количество готовых ML-моделей, которые не требуют значительных ресурсов на доработку под специфику конкретной клиентской задачи – все это ведет к росту числа компаний, включающих в свой ИT-ландшафт ML-сервисы. Мы стремимся обеспечить нашим клиентам широкий выбор эффективных решений, которые позволят применять ML-модели даже без опыта. Запуск Inference-платформы является логичным шагом в этом направлении».

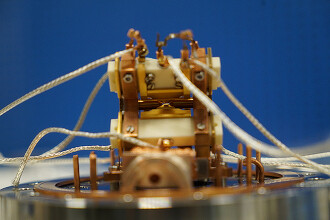

Платформа построена на базе GPU-кластеров Managed Kubernetes Selectel и дополнена популярными open-source инструментами Nvidia Triton Inference Server, Ray Serve Cluster и Istio Ingress Controller. Таким образом, решение полностью независимо от vendor lock (привязки к поставщику) и обеспечивает высокую производительность за счет встроенных возможностей по повышению пропускной способности и максимальной утилизации ресурсов.

Поделиться

Поделиться